Implementar ética nos processos é o segredo para desenvolver uma IA transparente e segura

Princípios do código aberto, como a cultura participativa e colaboração integrada, são os catalisadores para impulsionar avanços da tecnologia.

A Inteligência Artificial (AI) é uma força motriz na inovação tecnológica, transformando setores e remodelando a forma como interagimos com a tecnologia. A IA pública e aberta, que enfatiza o compartilhamento de modelos, datasets e metodologias, está no centro desta evolução. Alinhar-se a princípios open source e alimentar a colaboração democratiza o acesso à IA e ajuda a acelerar os avanços, ainda que existam uma série de desafios éticos complexos, especialmente quando se trata de equilibrar ética, transparência e segurança nos processos de tecnologia.

Aplicando princípios open source à IA

Modelos de IA públicos e privados operam com base nos ideais fundamentais de transparência, inclusão e colaboração. Isso envolve compartilhar abertamente a pesquisa, código e ferramentas para permitir que um número maior de desenvolvedores, pesquisadores e organizações contribua e se beneficie de avanços tecnológicos.

Os princípios essenciais se baseiam na:

● Colaboração: compartilhar conhecimento e recursos impulsiona uma comunidade global de contribuidores, possibilitando descobertas que nenhuma entidade conseguiria alcançar sozinha.

● Acessibilidade: ao remover barreiras ao acesso, estes modelos de IA possibilitam que organizações menores, startups e instituições com menos recursos aproveitem ferramentas de última tecnologia.

● Responsabilização: a transparência garante que o desenvolvimento da IA possa ser avaliado em busca de vieses, erros e práticas antiéticas, criando sistemas mais justos e confiáveis.

Embora esses princípios tenham um potencial tremendo para democratizar a IA, eles também representam desafios significativos, particularmente em relação ao uso destas tecnologias.

O dilema do uso duplo de modelos de IA abertos e públicos

Um dos desafios éticos enfrentado nos modelos de IA públicos e abertos é o dilema do uso duplo, que é a possibilidade de que a IA possa ser usada tanto para propósitos benéficos quanto maléficos. A IA aberta e pública amplia este desafio, uma vez que qualquer pessoa com acesso a ferramentas ou modelos pode utilizá-los de outra forma, potencialmente para propósitos maléficos. Exemplos de desafios de uso duplo incluem, mas não se limitam a:

● Deepfakes: estes modelos de IA generativa podem criar imagens ou vídeos altamente realistas, porém falsos, o que pode ser aproveitado para gerar desinformação ou assédio.

● Riscos de cibersegurança: ferramentas de IA open source projetadas para automatizar tarefas também podem ser adaptadas para automatizar ataques de phishing ou identificar vulnerabilidades em sistemas.

● Violações de privacidade: datasets disponíveis publicamente, frequentemente usados para treinar IA, podem expor informações sensíveis ou pessoais sem querer.

Esses exemplos destacam a importância do desenvolvimento de proteções para evitar o uso inadequado enquanto mantemos os benefícios da abertura.

Transparência como um imperativo da ética

A transparência está no centro do desenvolvimento ético da IA. A IA aberta e pública floresce sob o princípio de que a transparência fomenta a confiança, responsabilização e colaboração. Ao tornar metodologias, fontes de dados e processos de tomada de decisão acessíveis, os desenvolvedores podem construir sistemas que sejam compreensíveis (IA transparente permite que os usuários vejam como as decisões são tomadas, gerando confiança), justos e colaborativos.

Equilibrando ética e transparência, colaboração e segurança

Alcançar um equilíbrio entre transparência, colaboração e segurança em IA aberta e pública requer uma abordagem ponderada. Existem várias estratégias para lidar com essa interação complexa.

- Compartilhamento responsável

● Transparência seletiva: os desenvolvedores podem compartilhar informações suficientes para promover a colaboração, ao mesmo tempo em que retêm detalhes confidenciais que podem permitir o uso indevido

● Acesso controlado: camadas de acesso a ferramentas avançadas, exigindo que os usuários sejam verificados, pode ajudar a gerenciar os riscos. - Padrões de segurança

Estabelecer padrões de segurança aceitos em vários locais é crucial para avaliar e comparar modelos. Estas referências devem consistir em:

● Testes para potenciais usos indevidos, como gerar resultados prejudiciais

● Avaliação da robustez contra investidas

● Medição da justiça entre diversos grupos demográficos - Transparência nas proteções

Os desenvolvedores devem compartilhar abertamente as salvaguardas embutidas nos sistemas de IA, como mecanismos de filtragem, ferramentas de monitoramento e diretrizes de uso. Esta transparência garante aos usuários a prevenção contra usos indevidos. - Encorajando a supervisão da comunidade

A comunidade de código aberto pode desempenhar um papel vital na identificação de vulnerabilidades e na sugestão de melhorias. Programas públicos de recompensa por bugs ou fóruns para discussões éticas podem aumentar tanto a segurança quanto a transparência.

Estudos de caso em colaboração ética

Modelos de IA orientados pela comunidade

Modelos de IA desenvolvidos colaborativamente enfatizando considerações éticas demonstram o poder dos princípios open source. Por exemplo, vários projetos conduzidos pela comunidade priorizam a transparência enquanto incorporam salvaguardas rigorosas para minimizar riscos.

Datasets compartilhados com anonimização

Projetos que liberam datasets públicos com técnicas de anonimização disponibilizam dados valiosos para treinamento enquanto protegem a privacidade individual. Estas iniciativas exemplificam como a abertura pode coexistir com formas éticas de lidar com dados.

Ferramentas open source para segurança

Ferramentas construídas colaborativamente, como estruturas de detecção de preconceito e imparcialidade de IA, mostram como a comunidade open source contribui para a segurança em sistemas de IA. Essas ferramentas são frequentemente desenvolvidas de forma transparente, o que convida ao feedback e aprimoramento.

O caminho adiante

Promover inovação e colaboração e, ao mesmo tempo, o equilíbrio entre transparência e segurança, está se tornando cada vez mais urgente à medida que a IA aberta e pública continua a crescer. O desenvolvimento ético requer um comprometimento coletivo de desenvolvedores, pesquisadores, formuladores de políticas e usuários para navegar pelos desafios e maximizar os benefícios.

Recomendações para o uso ético de IA

- Estabelecer diretrizes claras: desenvolver diretrizes éticas abrangentes para compartilhar modelos, ferramentas e conjuntos de dados de IA.

- Apoiar pesquisas sobre segurança: investir em pesquisa para abordar vulnerabilidades em IA aberta e pública, como robustez contra ataques de adversários e prevenção de uso indevido.

- Promover a colaboração ética: incentivar parcerias entre a academia, a indústria e as comunidades open source para criar sistemas de IA mais seguros e inclusivos

- Fomentar a educação e o conhecimento: equipar desenvolvedores e usuários com o conhecimento para entender e mitigar riscos éticos em IA

Em resumo

A ética da IA aberta e pública tem ampla sinergia com a transparência, a colaboração e a segurança. Embora a abertura impulsione a inovação e democratize o acesso às tecnologias de IA, ela também apresenta riscos significativos que exigem gerenciamento cuidadoso. Ao adotar estratégias como compartilhamento responsável e supervisão da comunidade, a comunidade de IA pode criar sistemas mais transparentes e seguros.

Em última análise, o objetivo é que os modelos de IA capacitem a sociedade, permitindo o progresso enquanto protegem contra danos. Esforços colaborativos e previsão ética são necessários para atingir um equilíbrio que sustente os princípios de abertura sem comprometer a segurança.

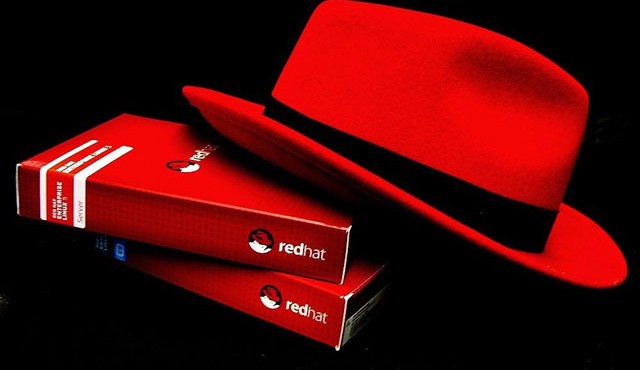

Para a Red Hat, “IA de código aberto não é apenas uma postura filosófica; é uma abordagem focada em desbloquear o verdadeiro valor da IA e torná-la algo muito mais acessível, muito mais democratizado e muito mais poderoso”.

Sobre a Red Hat

A Red Hat é a fornecedora líder mundial de soluções de código aberto empresarial, com uma abordagem voltada para a comunidade, a fim de fornecer tecnologias altamente confiáveis e de alto desempenho, como Linux, nuvem híbrida, containers e Kubernetes. A Red Hat ajuda os clientes a integrar aplicações de TI novas e existentes, fornecer desenvolvimento nativo da nuvem, padronizar e automatizar o sistema operacional líder do setor, além de proteger e gerenciar ambientes complexos. Serviços renomados de suporte, treinamento e consultoria fazem da Red Hat a consultora confiável para empresas Fortune 500. Como parceira estratégica para provedores de nuvem e aplicativos, integradores de sistemas, clientes e comunidades de código aberto, a Red Hat ajuda as organizações a se prepararem para o futuro digital.