Search On 2022: Multisearch em breve no Brasil, tradução em imagens com Lens, visão imersiva no Google Maps e muito mais

Em evento global realizado nesta quarta-feira (28), a empresa mostrou como está trazendo para seus produtos o Search On Multisearch com o que há de mais avançado em aprendizado de máquina para oferecer às pessoas formas mais naturais e intuitivas de pesquisar e explorar as informações.

O Google realizou nesta quarta-feira (28) seu evento anual Search On, onde mostrou como está trazendo para seus produtos inovações em aprendizado de máquina e recursos para oferecer às pessoas novas formas de pesquisar e explorar informações além da caixa de pesquisa.

“No Search On, mostramos hoje como os avanços na inteligência artificial estão nos permitindo transformar nossos produtos de informação mais uma vez. Estamos indo muito além da caixa de pesquisa para criar experiências de pesquisa que funcionem mais como nossas mentes e que sejam tão multidimensionais quanto somos como pessoas”, diz Prabhakar Raghavan, vice-presidente sênior da Busca no blog da empresa.

Confira a seguir mais detalhes sobre essas novidades anunciadas hoje no Search On 2022 Multisearch

Lançamentos na Busca

Multisearch em novos idiomas, incluindo português do Brasil

O recurso de Lens permite explorar o mundo ao nosso redor usando a câmera do celular ou uma imagem de tela. (Atualmente, as pessoas usam o Lens para responder a mais de oito bilhões de perguntas por mês!). O Google está trabalhando para deixar as pesquisas visuais cada vez mais naturais, graças à introdução do multisearch – um marco importante que traz possibilidades totalmente novas para pesquisar informações.

Com a nova modalidade de busca, é possível tirar uma fotografia ou usar uma imagem (ou um screenshot) e acrescentar texto a essa foto – da mesma forma com que a gente aponta para alguma coisa quando quer fazer uma pergunta sobre o que está vendo. O Multisearch já está disponível globalmente em inglês, e ao longo dos próximos meses será lançado em mais de 70 idiomas, incluindo em português-Brasil.

Como funciona: No aplicativo do Google, você pode tirar uma foto ou usar uma captura de tela e adicionar texto à imagem, assim como você pode apontar a câmera para algo e fazer uma pergunta sobre isso, de forma intuitiva e natural.

Perto de mim

Outra funcionalidade de Multisearch anunciada hoje foi o “perto de mim”. No aplicativo do Google, será possível tirar uma foto ou uma captura de tela e adicionar “perto de mim” para encontrar seu prato favorito ou um produto de fornecedores locais. O recurso estará disponível nos Estados Unidos ainda este ano.

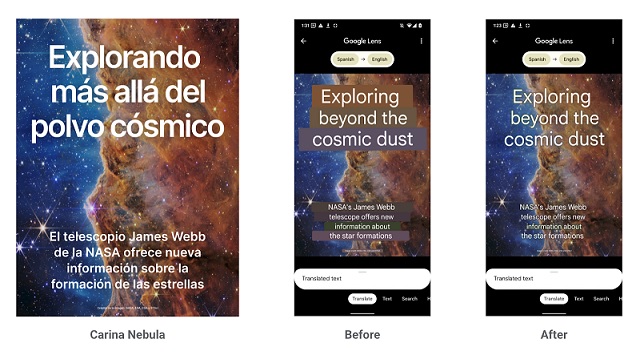

Traduzindo imagens com o Lens

Uma das características mais potentes de compreender o mundo visualmente é romper as barreiras dos idiomas. O Lens já ultrapassou a etapa de traduzir textos, e hoje é capaz de traduzir imagens. Todos os meses as pessoas usam o Google para traduzir mais de um bilhão de textos que estão sobrepostos a imagens, em mais de 100 línguas diferentes.

Grandes avanços na tecnologia de aprendizado de máquina permitem misturar textos traduzidos a imagens complexas, com um resultado tão natural que parece quase imperceptível.

Por meio do Tradutor com o Lens, ao invés de cobrir o texto original, ele passa a ser apagado. Ou seja: os pixels são recriados sobre um fundo gerado por inteligência artificial (IA), e o texto traduzido é sobreposto à imagem.

Otimizamos os modelos de aprendizado de máquina e agora fazemos todo esse processo em apenas 100 milissegundos — menos que um piscar de olhos. Essa experiência aprimorada será lançada globalmente até o final do ano.

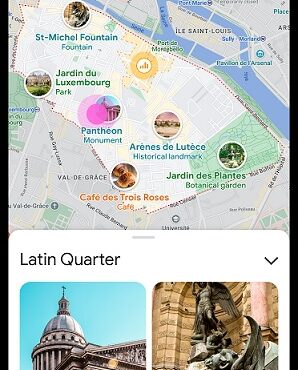

O recurso “neighborhood vibe” (atmosfera da vizinhança, em tradução livre) permite escolher um bairro e conhecer seus pontos mais populares, como se a pessoa estivesse lá, por meio de fotos e informações úteis compartilhadas no próprio mapa por integrantes da comunidade Google Maps. Para fazer isso, o Google combinou a inteligência artificial aos conhecimentos locais de usuários do Maps que contribuem diariamente com mais de vinte milhões de avaliações, fotos e vídeos. Essa experiência visual começará a ser lançada globalmente para Android e iOS nos próximos meses

Mais facilidade para perguntar

A plataforma está introduzindo novas experiências de pesquisa que refletem melhor como as pessoas exploram as informações naturalmente, começando por tornar mais fácil fazer perguntas.

Agora, à medida que você começa a digitar na caixa de pesquisa, a Busca fornece opções de palavras-chave ou tópicos para ajudar a elaborar a pergunta. Se a pessoa estiver procurando um destino no México, a Busca o ajuda a especificar a pergunta — por exemplo, “melhores cidades no México para famílias” — para que a pessoa possa obter resultados os mais relevantes para ela. O lançamento do recurso será feito nos EUA, em inglês, nos próximos meses.

Jeitos mais visuais de explorar no Search On Multisearch

Agora ficou mais fácil explorar um assunto destacando as informações mais relevantes e úteis – incluindo conteúdo de criadores da internet. Para temas como “cidades”, por exemplo, será possível vídeos curtos de pessoas que já estiveram naquele lugar, além de dicas sobre como conhecer o local, atividades, como chegar lá e outras informações que ajudam na etapa de planejamento da viagem. Tudo isso será lançado em inglês, nos Estados Unidos, ao longo dos próximos meses. Veja mais aqui.

Novidades no Google Maps

Aproveitamos os recursos mais avançados de visão por computador e modelos preditivos para dar uma turbinada nos mapas 2D. Eles estão ainda mais visuais e imersivos, e permitem “entrar” nos lugares de forma multidimensional. Com isso, a gente se sente como se estivesse lá, mesmo não estando.

Panoramas aéreos de marcos importantes

Confira 250 panoramas aéreos foto-realistas de grandes marcos globais, como a Torre de Tóquio ou a Acrópole grega, sem sair do Google Maps. Essa novidade é um grande avanço rumo a mapas cada vez mais imersivos, e está sendo lançada hoje em todo o mundo.

Visão imersiva

A visão imersiva ajuda as pessoas a se planejar com antecedência e entender a fundo várias cidades. Ela combina belíssimos panoramas aéreos a informações sobre tempo e temperatura, trânsito e lotação de pessoas em diferentes horários e dias da semana.

O novo recurso será lançado ao longo dos próximos meses em Los Angeles, Londres, Nova York, São Francisco e Tóquio.

Busca em Live View

O recurso Busca em Live View permite fazer pesquisas de um jeito totalmente inédito. Basta apontar a câmera do celular para encontrar lugares essenciais como lojas, caixas eletrônicos e restaurantes. Tudo isso enquanto você está em movimento.

A novidade será lançada ao longo dos próximos meses em Londres, Nova York, Paris, São Francisco e Tóquio.

Anúncios e tendências em Shopping

Anunciamos novos produtos e ferramentas que vão facilitar ainda mais a vida de quem quer comprar o que precisa e descobrir produtos incríveis. Entre elas estão novos recursos visuais na Busca – que ajudam a inspirar o usuário -, além de ferramentas para tomar a melhor decisão no caso de compras complexas e atualizações que garantem uma experiência sob medida. Veja mais tendências em

nosso blogpost.

Para mais informações sobre todos os lançamentos de Search On, acesse o blog do Google aqui e aqui (em inglês).

Leia também:

Google anuncia solução que busca mais transparência na mídia programática

PicPay e Google Play lançam parceria para compras de apps e entretenimento

.