Por Animesh Singh, Christian Kadner e Tommy Chaoping Li

Com contribuições da equipe MLX, como Andrew Butler e Romeo Kienzler

No ciclo de vida da Inteligência Artificial (IA), utilizamos dados para construir modelos para a automação da tomada de decisão. Conjuntos de dados, modelos e pipelines, que transformam conjuntos de dados brutos em modelos implantados, são os três pilares mais críticos desse ciclo. Devido ao grande número de etapas envolvidas no ciclo de vida dos dados e IA, o processo de construção de um modelo pode ser dividido em múltiplas equipes e levar a várias duplicações ao construir Datasets, Features, Models, Pipelines e Pipeline tasks semelhantes. Por sua vez, isso representa um grande desafio em termos de rastreabilidade, governança, gerenciamento de risco, rastreamento de linhagem e coleta de metadados.

Apresentamos o Machine Learning eXchange (MLX)

Para superar esses problemas, precisamos de um repositório central onde todos os diferentes tipos de ativos são armazenados para serem compartilhados e reutilizados além dos limites da organização. Verificar e testar Datasets, Models e Pipelines com controles de alta qualidade, licenças correspondentes e rastreamento de linhagem, proporciona um grande aumento na velocidade e a eficiência do ciclo de vida da IA.

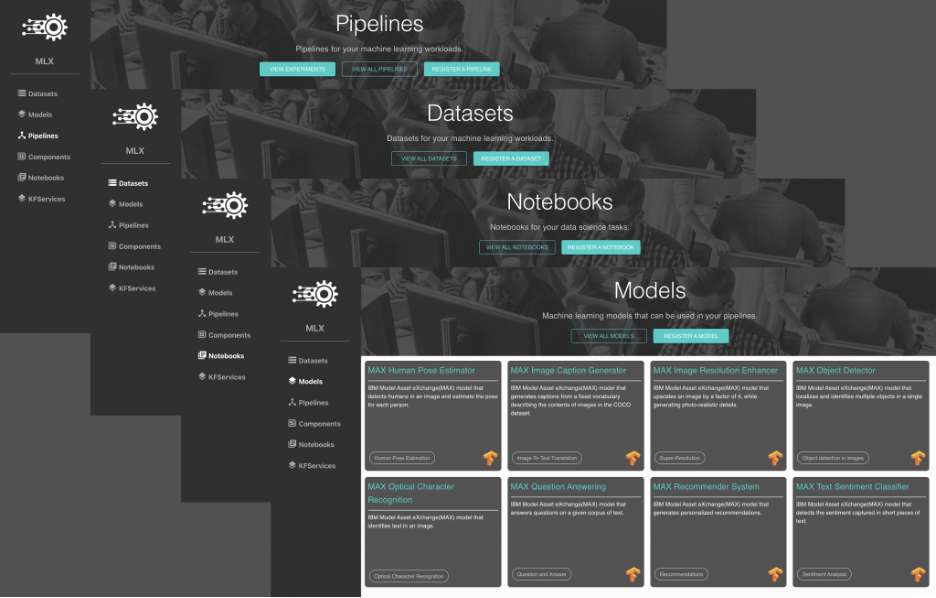

Para resolver esses desafios, a IBM e a Linux Foundation AI and Data (LFAI and Data) unem forças para anunciar o Machine Learning eXchange (MLX), um catálogo de ativos de dados e IA e engine de execução em Código Aberto e Governança Aberta. O Machine Learning eXchange (MLX) permite fazer upload, registrar, executar e implantar pipelines de IA e componentes de pipeline, modelos, datasets e notebooks.

Arquitetura Machine Learning eXchange

Machine Learning eXchange oferece:

- Geração automatizada de código de pipeline de amostra para executar modelos registrados, conjuntos de dados e notebooks

- Pipeline Engine com tecnologia Kubeflow Pipelines on Tekton, o coração do Watson Studio Pipelines

- Registro para componentes Kubeflow Pipeline

- Gerenciamento de Datasets com Datashim

- Service Engine KFServing

Ativos do catálogo Machine Learning eXchange

Pipeline

No aprendizado de máquina ou Machine Learning, é comum realizar uma sequência de tarefas para processar e aprender com os dados, todas as quais podem ser compactadas em um pipeline. Os pipelines do aprendizado de máquina são:

- Uma maneira consistente de colaborar em projetos de ciência de dados além dos limites da organização e da equipe.

- Uma coleção de tarefas gerais encapsuladas como componentes de pipeline que se encaixam como peças de Lego.

- Um recurso único para pessoas interessadas em treinar, validar, implementar e monitorar modelos de IA.

Alguns exemplos de pipelines incluídos no catálogo MLX: Trusted AI Pipeline (with AI Fairness 360 and Adversarial Robustness 360) , Hyperparameter Tuning e Nested Pipeline.

Componentes de Pipeline

Um componente de pipeline é um conjunto código autônomo que executa uma etapa no fluxo de trabalho de aprendizado de máquina (pipeline), como aquisição de dados, pré-processamento de dados, transformação de dados e treinamento do modelo. Um componente é um bloco de código que executa uma tarefa atômica e pode ser escrito em qualquer linguagem de programação e usando qualquer framework. Alguns dos componentes do pipeline no catálogo MLX incluem: Create Dataset Volume with DataShim, Deploy a Model on Kubernetes, Adversarial Robustness Evaluation e Model Fairness Check.

Modelos

O MLX fornece uma coleção de modelos de deep learning de próxima geração gratuitos e de código aberto para domínios de aplicativos comuns. A lista selecionada inclui modelos implantáveis que podem ser executados como um micro serviço no Kubernetes ou OpenShift e modelos treináveis, que podem ser treinados pelos usuários com seus próprios dados. Alguns modelos incluídos no catálogo MLX são, entre outros: Human Pose Estimator, Image Caption Generator, Recommender System e Toxic Comment Classifier.

Datasets

O catálogo MLX contém conjuntos de dados reutilizáveis e aproveita o Datashim para disponibilizar os conjuntos de dados para outros ativos MLX, como notebooks, modelos e pipelines na forma de volumes Kubernetes. Alguns dos conjuntos de dados oferecidos são, entre outros: Finance Proposition Bank, NOAA Weather Data – JFK Airport, Thematic Clustering of Sentences e TensorFlow Speech Commands.

Notebooks

O aplicativo web de código aberto, Jupyter notebook, permite que os cientistas de dados criem e compartilhem documentos que contêm código executável, equações, visualizações e texto narrativo. O MLX pode executar Jupyter notebooks como conteúdo de pipeline autônomo, aproveitando o projeto Elyra-AI. Alguns dos notebooks disponíveis no MLX são, entre outros: AIF360 Bias Detection, ART Poisoning Attack, JFK Airport Analysis e Project CodeNet Language Classification.

O Machine Learning Exchange fornece um marketplace e uma plataforma para cientistas de dados compartilharem, executarem e colaborarem em seus ativos. A solução pode ser usada para hospedar e colaborar em ativos de dados e IA dentro de uma equipe ou integrada a outros times.

Participe do Machine Learning eXchange github repo para experimentar, compartilhar suas ideias e levantar questões. Para contribuir e construir pipelines de aprendizado de máquina no OpenShift e Kubernetes, junte-se ao projeto Kubeflow Pipelines on Tekton. Sinta-se à vontade para nos enviar seus comentários, perguntas e feedback!

Para implantar modelos de aprendizado de máquina na produção, veja mais informações sobre o projeto KFServing.

Links MLX: Website, GitHub, Artwork

Listas de distribuição: MLX-Announce, MLX-Technical Discuss, MLX-TSC

Assessoria de imprensa IBM

Weber Shandwick

E-mail: [email protected]